集成学习,顾名思义,通过集成多个机器学习模型来构建更强大的模型。

用一句俗语来说,就是三个臭皮匠顶个诸葛亮。

在集成学习这个“江湖”中,主要有两个流派:Bagging流派和Boosting流派。

Bagging流派

Bagging是bootstrap aggregating的缩写,bootstrap表示自助抽样法,是一种有放回的随机抽样,aggregating表示合计、聚合的意思。

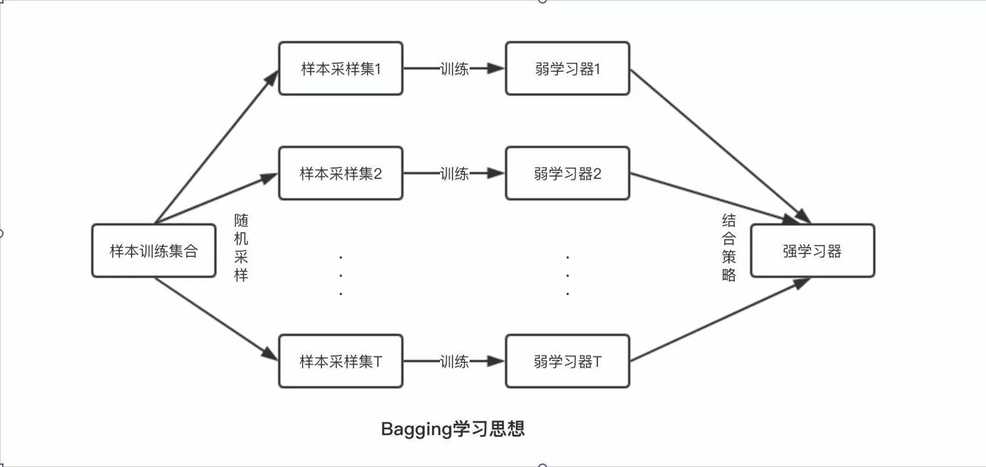

Bagging的基本思想如下图所示。

这个图表示的是对样本数据进行随机抽样,训练N个模型(弱学习器),然后将这N个弱学习器组合成一个强学习器。

从图中可以看到,这N个弱学习器是通过“并行”的方式组合成一个强学习器。

Bagging算法中的典型代表就是随机森林。

随机森林由多个决策树组成,其构造过程分为以下三步。

1、通过对样本数据进行随机抽样,对数据的行(样本)和列(特征)都进行抽样。

2、用第1步得到的多个样本数据,训练出多棵决策树。

3、预测,每一棵树都会给出一个预测结果,对每一棵树的预测结果进行投票,哪个类别多,输入样本就属于哪个类别。

Boosting流派

英文单词Boosting表示提升的意思,也叫提升方法。

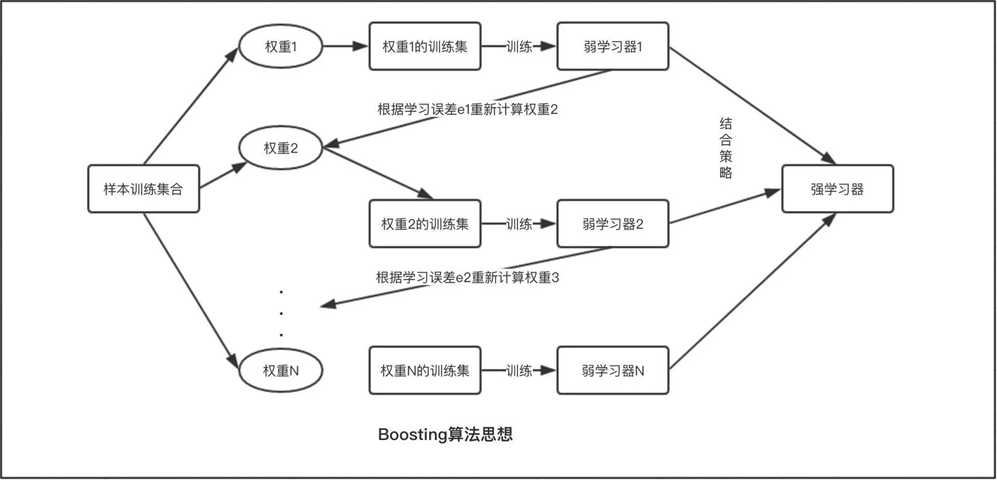

Boosting的基本原理如下图所示。

这个图表示开始训练前,给每一个样本赋一个权重,然后用这个具有权重的训练集训练一个弱学习器,每次训练后,根据误差调整权重,再进行训练,如此往复,训练N次,最后得到一个强学习器。

也就是说通过不断地使用一个弱学习器弥补前一个弱学习器的“不足”的过程,来“串行”地构造一个较强的学习器。

Boosting算法中的典型代表有梯度提升决策树、AdaBoost及XGBoost等。

这里说一下梯度提升决策树。

梯度提升决策树,英文名称是Gradient Boosting Decision Tree,是一种基于决策树的集成学习方法。

梯度提升决策树通过连续不断地构造决策树,每一棵树都试图纠正前一棵树的错误,串行地构造一个强学习器。

总结

- 集成学习:合并多个机器学习模型来构建更强大的模型

- 两个流派:Bagging流派和Boosting流派

- Bagging和Boosting都是把若干个分类器整合为一个分类器的集成学习方法,只是整合的方式不一样,最终得到不一样的效果。

- 随机森林和梯度提升决策树是两种常用的继承学习方法,都以决策树作为基础